Paläoklima: Das ganze Holozän

BLOG: KlimaLounge

Eine Forschergruppe von den Harvard und Oregon State Universitäten hat in Science die erste globale Temperaturrekonstruktion für die vergangenen 11,000 Jahre publiziert – das ganze Holozän. Die Ergebnisse besprechen wir hier in Teil 3 unserer kleinen Paläoklima-Serie.

Im ersten Teil haben wir die neue Klimarekonstruktion des PAGES 2k Projekts für die vergangenen 2000 Jahre diskutiert. Aber was kam davor? Reicht der langfristige Abkühlungstrend noch weiter in die Vergangenheit zurück?

Über die letzten Jahrzehnte haben zahlreiche Forscher in mühsamer Kleinarbeit viele Datenreihen z.B. aus Sedimentbohrungen in der Tiefsee gewonnen, analysiert, datiert, kalibriert usw. Nun haben Shaun Marcott und Kollegen erstmals 73 solcher Datenreihen aus aller Welt zu einer globalen Temperaturrekonstruktion für das Holozän zusammengefügt. Oder genau genommen zu vielen: sie haben rund zwanzig verschiedene Mittelungsmethoden ausprobiert und außerdem 1000 Monte-Carlo-Simulationen mit zufälligen Datierungsfehlern der einzelnen Datenreihen durchgeführt, um die Robustheit ihrer Ergebnisse zu belegen.

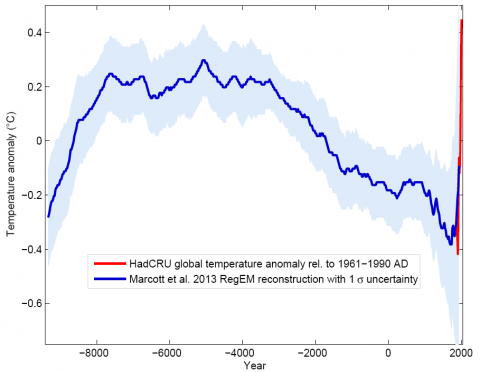

Um das Hauptergebnis gleich vorweg zu nehmen, es sieht so aus:

Abb. 1. Blaue Kurve: Globale Temperaturrekonstruktion aus Proxydaten von Marcott et al., Science 2013. Gezeigt ist die RegEM-Version – nennenswerte Unterschiede zwischen den Varianten mit verschiedenen Mittelungsmethoden gibt es allerdings ohnehin nur gegen Ende, wo die Zahl der Proxyreihen abnimmt, wo der Verlauf aber aus instrumentellen Messungen gut bekannt ist. Rote Kurve: Globale Temperatur aus Messdaten (HadCRU). Grafik: Klaus Bittermann.

Der Klimaverlauf ähnelt einem „Buckel“. Zu Beginn des Holozän – nach Ende der letzten Eiszeit – ist die globale Temperatur gestiegen, in den letzten 5000 Jahren dagegen um 0,7 °C gefallen. Der bekannte Übergang vom relativ warmen Mittelalter in die „kleine Eiszeit“ erweist sich als Teil einer viel langfristigeren Abkühlung, die mit der rasanten Erwärmung im 20. Jahrhundert ein jähes Ende gefunden hat. In nur hundert Jahren wurde die Abkühlung von 5000 Jahren wettgemacht. (Eine Folge ist z.B., dass der vor 5000 Jahren unter dem Eis verschwundene Eismensch Ötzi 1991 wieder zum Vorschein gekommen ist.)

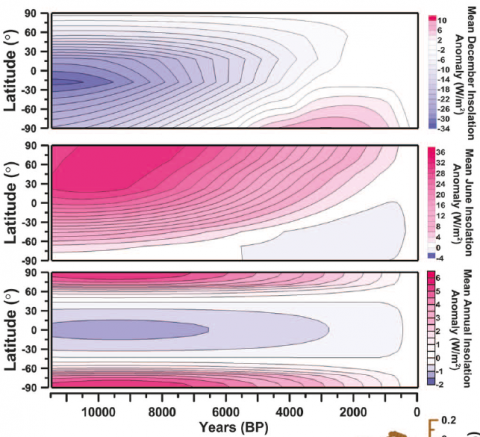

Der Verlauf der Kurve kommt für Klimaforscher nicht überraschend und passt zum Antrieb durch die Orbitalzyklen, die wir in Teil 1 bereits angesprochen haben. Marcott et al. zeigen dazu diese Grafik:

Abb. 2. Veränderungen der Sonneneinstrahlung in Abhängigkeit vom Breitengrad im Dezember, Juni und Jahresmittel, aufgrund der astronomischen Milankovic-Zyklen. Quelle: Marcott et al. 2013.

Im untersten Panel sieht man die Sonneneinstrahlung im Jahresmittel, abhängig von Zeit und Breitengrad. Sie hat in den mittleren bis hohen Breiten über das Holozän stark abgenommen, in den Tropen dagegen etwas zugenommen. In der Marcott-Rekonstruktion ist der globale Temperaturverlauf vor allem durch die starken Veränderungen in nördlichen Breiten (30-90° Nord) dominiert. Für diese ist das oberste mittlere Panel besonders relevant: das Sommermaximum der Einstrahlung. Das nimmt im Verlauf des Holozäns massiv ab – um mehr als 30 Watt pro Quadratmeter. (Zum Vergleich: dass anthropogene CO2 in der Atmosphäre erzeugt nur einen Strahlungsantrieb von knapp 2 Watt pro Quadratmeter – allerdings weltweit und über das ganze Jahr.) Das Klimasystem reagiert besonders empfindlich auf diese Sommereinstrahlung, weil sie durch die Schnee- und Eis-Albedo-Rückkopplung verstärkt wird. Sie ist auch in der Milankovic-Theorie der bestimmende Faktor für die Eiszeitzyklen – das starke Maximum zu Anfang des Holozän ist der Grund, weshalb die eiszeitlichen Eismassen verschwanden.

Vergleich mit PAGES 2k

Die verwendeten Daten unterscheiden sich von denen des PAGES 2k Projekts (nur Land-Daten) hauptsächlich darin, dass sie zu 80% aus Tiefseesedimenten stammen. Sedimente reichen weiter zurück (noch viel viel weiter als nur durch das Holozän – aber das ist eine andere Geschichte). Anders als Baumringdaten, die hauptsächlich für die letzten zweitausend Jahre geeignet sind und nur selten weiter reichen. Dafür haben die Sedimentdaten eine schlechtere zeitliche Auflösung und reichen nicht bis an die Gegenwart heran, weil die Oberfläche des Sediments bei der Entnahme des Kerns gestört wird. Auch die Methoden der Temperaturbestimmung sind ganz andere als bei den Landdaten; als Proxies werden hier z.B. die Konzentration von Sauerstoff-Isotopen oder das Verhältnis von Magnesium zu Calcium in den Kalkschalen von Mikroplankton verwendet, die jeweils eine gute Korrelation mit der Wassertemperatur aufweisen. So kann man jeden Sedimentkern einzeln kalibrieren, sodass man daraus eine Temperatur-Zeitreihe für den jeweiligen Ort erhält.

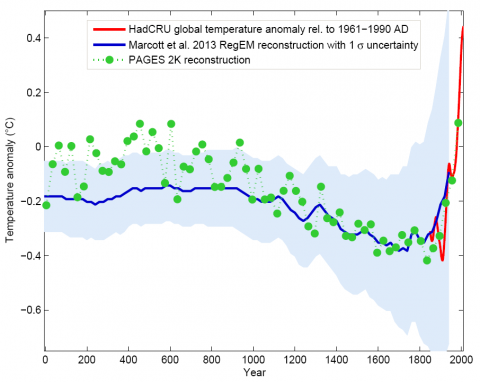

Insgesamt ist die neue Marcott-Rekonstruktion weitestgehend unabhängig von und schön komplementär zu der PAGES 2k Rekonstruktion: Ozean statt Land, ganz andere Methodik. Daher ist ein Vergleich zwischen beiden interessant:

Abb. 3. Die letzten zweitausend Jahre von Abb. 1 im Vergleich mit der PAGES-Rekonstruktion (grün), die in Teil 1 von uns näher erläutert wird. Grafik: Klaus Bittermann.

Wie wir sehen ergeben beide Rekonstruktionsmethoden konsistente Ergebnisse. Dass der Verlauf in den letzten eintausend Jahren praktisch identisch ist, ist übrigens auch eine weitere Bestätigung des „Hockeyschlägers“ von Mann et al. 1999 – siehe Teil 2 dieser Serie, Die Hockeyschläger-Debatte.

Ist die moderne Erwärmung einmalig?

Wegen der oben erwähnten Grenzen der Sedimentkerne reicht die neue Rekonstruktion nicht bis an die Gegenwart sondern geht nur bis zum Jahr 1940, und die Zahl der verwendeten Datenkurven nimmt schon deutlich vorher stark ab. (Daher wird auch der gezeigte Unsicherheitbereich am Ende immer breiter und die Rekonstruktionen mit verschiedenen Mittelungsmethoden divergieren hier – wir zeigen hier die RegEM Methode, weil die am besten mit der abnehmenden Datenabdeckung klar kommt – für eine eingehende Analyse siehe den Blog von Grant Foster, der professioneller Statistiker ist). Die Erwärmung im 20. Jahrhundert wird also nur ansatzweise erfasst – was allerdings nicht gravierend ist, weil diese Erwärmung ja durch Wetterstationen bestens dokumentiert ist. Am Klimaverlauf im 20. Jahrhundert bestehen keine Zweifel.

Daher besteht auch ein gewisser Spielraum, wie man die Proxydaten (blau) mit den Thermometerdaten (rot) zusammenfügt – ich habe das hier so gemacht, dass für den Zeitraum 1000 – 1940 AD der Mittelwert der Marcott-Kurve und der PAGES 2k-Rekonstruktion gleich gesetzt werden. Ich halte das für besser als die Wahl von Marcott et al. (deren Paper aber auch vor PAGES 2k publiziert wurde) – aber es ist unwichtig. Von der relativen Position der Kurven hängt es ab, ob die Temperaturen am Ende etwas höher sind als je zuvor im Holozän, oder nur (wie Marcott et al. schreiben) als während 85% des Holozäns. Ich würde sagen: sie sind annähernd so hoch wie im Optimum des Holozäns, vielleicht knapp kühler, vielleicht knapp wärmer. Das ist nicht entscheidend.

Entscheidend ist vielmehr, dass der rasche Anstieg im 20. Jahrhundert im ganzen Holozän einmalig ist. Ob das wirklich so ist, darüber wurde nach Erscheinen des Papers in den Blogs intensiv diskutiert. Denn die Proxydaten haben nur eine grobe zeitliche Auflösung – hätten sie es überhaupt erfasst, wenn es im Holozän schon einmal eine ähnlich rasche Erwärmung gegeben hat?

Ich halte es aus drei Gründen für praktisch sicher, dass es eine so rasche Erwärmung noch nicht gab:

- Es gibt auch eine Reihe von hochaufgelösten Proxydaten über das Holozän, z.B. die Eiskerne aus Grönland und der Antarktis. Sie zeigen einen glatten Verlauf ohne eine frühere starke Erwärmung wie im 20. Jahrhundert. Hätte es eine solche globale Erwärmung schon einmal gegeben, müsste man sie zumindest in einigen Datenreihen deutlich sehen, selbst wenn sie in der gemittelten Marcott-Kurve untergeht.

- Grant Foster hat die Probe aufs Exempel gemacht und einige solche Erwärmungs-Spikes in einem Teil der Proxydaten versteckt, um zu sehen, ob sie von der Methode von Marcott et al. aufgezeigt werden – die Antwort ist ein klares Ja, sie würden (wenn auch gedämpft) auch in der gemittelten Kurve auftauchen, siehe seinen Artikel dazu.

- Eine solche Erwärmung muss einen physikalischen Grund haben, und sie muss rasch wieder verschwinden (hätte sie länger angehalten, wäre sie ja umso deutlicher in den Proxydaten sichtbar). Es gibt keinerlei Hinweise in den Forcing-Daten, dass ein solcher Klimaantrieb plötzlich aufgetaucht und wieder verschwunden sein könnte, und ich kann mir auch nicht vorstellen, was der Mechanismus gewesen sein sollte. (Eine CO2-bedingte Erwärmung würde z.B. lange anhalten, weil die CO2-Konzentration erst über Jahrtausende wieder abklingt – und Daten über die Konzentration von CO2 und anderer Treibhausgase haben wir ja auch für das Holozän.)

Fazit

Die Kurve (oder besser Kurvenschar) von Marcott et al. ist natürlich nicht das letzte Wort über den globalen Temperaturverlauf im Holozän; wie damals Mann et al. ist sie die Eröffnung der Diskussion. Es wird sicher alternative Vorschläge geben und hier und da Korrekturen und Verbesserungen. Dennoch glaube ich, dass der Verlauf (auch das wie bei Mann et al.) in den großen Zügen stimmen dürfte. Ein relativ glatter Verlauf mit einer seit Jahrtausenden anhaltenden langsamen Abkühlung vom Holozänen Optimum bis zur “kleinen Eiszeit”, angetrieben vor allem vom Zyklus der Erdachsenneigung. Am Ende jäh unterbrochen durch die anthropogene Erwärmung.

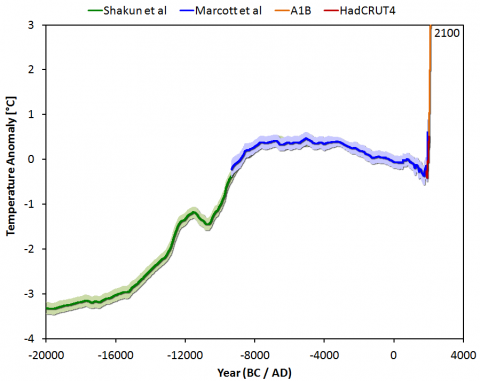

In der folgenden Grafik ist die Marcott-Rekonstruktion noch um etwas Kontext ergänzt: die Erwärmung am Ende der letzten Eiszeit (die vor 20.000 Jahren ihren Höhepunkt erreichte) und eine mittlere Projektion für die erwartete Erwärmung im 21. Jahrhundert, wenn die Menschheit nicht rasch den Ausstoß von Treibhausgasen verringert.

Abb. 4. Globaler Temperaturverlauf seit der letzten Eiszeit vor 20.000 Jahren, bis zum Jahr 2100 verlängert für ein mittleres Emissionsszenario mit etwa 3 Grad globaler Erwärmung. Grafik: Jos Hagelaars.

Marcott et al. merken zu dieser Zukunftsaussicht lapidar an:

By 2100, global average temperatures will probably be 5 to 12 standard deviations above the Holocene temperature mean.

Auf gut Deutsch: wir sind dabei, uns weit aus dem Holozän herauszukatapultieren.

Die Betrachtung der bekannten Strahlungsantriebe und des rekonstruierten Temperaturverlaufs spricht schon ohne jedes Klimamodell direkt dafür, dass ohne den vom Menschen verursachten Treibhausgasanstieg der langsame Abkühlungstrend weitergegangen wäre. Wahrscheinlich ist daher praktisch die komplette Erwärmung im 20. Jahrhundert auf den Menschen zurückzuführen.

Die Konzentration von CO2 in der Erdatmosphäre hat im Mai erstmals seit mindestens einer Million Jahre die Schwelle von 400 ppm überschritten. Wenn wir diesen Trend nicht sehr rasch stoppen, werden wir unsere Erde am Ende des Jahrhunderts nicht mehr wiedererkennen.

Übersicht über unsere Paläoklimareihe

Teil 1: Die letzten 2000 Jahre Detaillierter als je zuvor sind jetzt die vergangenen 2000 Jahre der Klimaentwicklung rekonstruiert worden.

Teil 2: Die Hockeyschläger-Debatte Wie auch deutsche Medien ein unliebsames Forschungsergebnis zu diskreditieren versuchen.

Teil 3: Das ganze Holozän Die erste globale Klimarekonstruktion für die letzten 11,000 Jahre.

Frage

Wir haben diesen interessanten Artikel auf d. Facebookseite Springer Spektrumgeo gepostet: http://www.facebook.com/springerspektrumgeo

Da kam folgende FRage auf:

Ben hat geschrieben: „wie hoch sind die die zeitlichen abstände zwischen den messungen vor der industriellen zeit?“

Möchten Sie darauf antworten?

[Antwort: Die Abstände sind bei den verwendeten Datenreihen unterschiedlich – eine detaillierte Diskussion zur zeitlichen Auflösung bietet der oben schon verlinkte Artikel Smearing climate data von Grant Foster. Stefan Rahmstorf]

Zweifelhafte Rekonstruktionen

Zur Rekonstruktion von Shaun Marcott:

http://www.kaltesonne.de/?p=9800

Zur PAGES2k-Rekonstruktion:

http://climateaudit.org/?s=pages2k

PAGES, jene Studie, die zuerst beim Science Magazin eingereicht wurde und dort durchgefallen ist und deshalb erneut bei Nature eingericht werden musste. Dort wurde sie zum letztmöglichen Termin durchgewunken, um im IPCC Bericht noch beruecksichtigt werden zu koennen.

Das Ergebnis einer ersten Analyse von Steve McIntyre ist einfach nur erschreckend, siehe Link oben.

Nun ist auch klar, warum die Studie noch nicht einmal bei Nature trotz vermutlich gewaltigen Drucks als peer reviewter “Research Article” durchging, sondern gerade mal als “Progress Article”.

[Antwort: Dass die Klimaskeptiker-Webseiten über dieses Ergebnis herfallen, wie seinerzeit über Mann et al., ist klar. Sie bieten hier einiges an Verschwörungstheorie, aber haben Sie auch ein Sachargument? Wir sind hier ein Wissenschaftsblog – wenn Sie eine konkrete Kritik an der Marcott-Rekonstruktion haben, können wir sie hier gerne diskutieren. Stefan Rahmstorf]

die sog. Mittelalterliche Warmzeit..

..ist ja so eine Art Bastion der Klimaskeptikerszene.

Liest man sich den Wikipedia Eintag darüber durch, scheint immer noch ‘kontrovers’ diskutiert zu werden ob die MWP mit der aktuellen Klimaerwärmung verglichen werden kann.

Abb. 3 zeigt deutlich, wie lächerlich das ist. (Vorausgesetzt es stecken in den

Page- und GLEICHZEITIG den Marcott-Rekonstruktionen keine groben Fehler.)

Da sowohl Messmethoden als auch Auswertungsmethoden transparent sind, müsste das aufdecken grober Fehler einem scharfsinnigen Skeptiker (Skeptiker hier im ursprünglichen positiven Sinne) ja auch anhand von Fakten möglich sein, ohne auf Fälschungen, oder Verschwörungstheorien zurückzugreifen.

Hat sich da nicht ein Fehler eingeschlichen?

Für diese ist das oberste Panel besonders relevant: das Sommermaximum der Einstrahlung.

Gemeint ist doch sicher das mittlere Panel.

[Antwort: Ja, danke! Stefan Rahmstorf]

Analog zum “Hockeyschläger” wurde auch schon ein Name für die neue Grafik in Abb.4 vorgeschlagen: der “Rollstuhl”…

Jüngere Dryas

Der Haken im grünen Teil der Kurve, Abb.4, dürfte wohl die “Jüngere Dryas” abbilden. Abseits des Mainstreams sind einige Wissenschaftler der Meinung, daß der scharfe Kälterückfall durch einen Impakt eines Himmelskörpers ausgelöst worden sein könnte.

Ungereimtheiten

Sehr geehrter Herr Prof. Rahmstorf,

in meinen Augen gibt es hier einige Ungereimtheiten:

1. Wieso ist dieser Peak am Ende der Kurve nicht in Marcotts Dissertation enthalten?

2. Wie können kurzzeitige Temperaturänderungen im 20. Jhdt. (Größenordnung: einige Jahrzehnte) verglichen werden mit Daten, deren zeitliche Auflösung mehrere hundert Jahre betragen? Ähnliche kurzzeitige Schwankungen blieben in den Paläodaten unentdeckt, auch wenn sie aufgetreten sein sollten. Das Nyquist-Shannonsche Abtasttheorem verbietet solche Vergleiche, die ja völlig sinnfrei sind.

3. Woher nehmen Marcott et al. die Expertise, Proxydaten umzudatieren, nachdem diese zuvor von ausgewiesenen Experten datiert wurden? Soweit ich informiert bin, wurden einzelne Proxies massiv umdatiert (z.B. Daten der MWP um ~1000 Jahre nach hinten verschoben).

4. Wie kann man die Temperaturanomalien verschiedener Proxies mitteln, wenn diese unterschiedliche Endpunkte aufweisen?

Beispiel: 3 fiktive – jeweils konstante – Proxies mit unterschiedlichem End-Datum:

-1 -1 -1 -1 -1

0 0 0 0 0

+1 +1 +1 +1 +1 +1 (ein Eintrag länger!)

–> Mittelwert:

0 0 0 0 0 +1 –> Hockeystick

Für eine Beantwortung dieser Fragen wäre ich sehr dankbar.

MfG

Werner Kohl

[Antwort: Ich bin in dem obigen Beitrag ja ausführlich auf die von Ihnen hier wieder vorgebrachten Einwände von den Klimaskeptikerblogs eingegangen – insbesondere auf die Erwärmung im 20. Jahrhundert und die Frage, ob eine ähnliche Erwärmung früher im Holozän von diesen Proxidaten nicht erfasst worden sein könnte. Einfach diese Dinge zu wiederholen, ohne im Geringsten auf meine Argumente dazu einzugehen, ist eine sterile Form der Debatte. Um die Diskussion voranzubringen, müssten sie doch Einwände formulieren – z.B. erklären, weshalb der konkrete Test von Grant Foster Sie nicht überzeugt hat, oder wie eine frühere globale Erwärmung stattgefunden haben könnte, ohne Spuren in den hoch aufgelösten Grönlanddaten zu hinterlassen.

Leider ist diese sterile Form des Diskurses von Seiten der „Klimaskeptiker“ nicht untypisch. In den Kommentarspalten werden endlos bereits widerlegte Argumente einfach formelhaft wiederholt – man muss den Eindruck gewinnen: von Menschen, die sie nicht wirklich beurteilen können, aber die gerne daran glauben – oder ihre Leser daran glauben lassen – wollen.

Stefan Rahmstorf]

Eine kleine Ergänzung

Sehr geehrter Herr Prof. Rahmstorf,

ich hatte noch vergessen zu erwähnen, dass Marcott auf Anfrage zugab, dass die Daten des 20. Jhdt. “nicht robust” seien.

Ich vermisse Ihren Hinweis darauf.

MfG

Werner Kohl

voll erwärmt

Im Ernst nun ist Ende Juni und ich frage mich, ob es eine gute Idee war die Sommerreifen aufzuziehen. Ich weiß ja mittlerweile (Danke Herr Professor), dass die ganze erwärmte Wärme im Ozean verschwunden ist, und dass es in den nächsten Jahren bestimmt noch viel wärmer wird, während es vor 30, 300 und 3000 viel kälter war als heute. Meine Frage ist nun: Warum hatten die Leute damals überhaupt Sommerreifen?

@Dr. Brecht

Deutschland umfasst zusammen mit seinen kleineren Nachbarstaaaten (Schweiz, Österreich, Benelux) grob gerundet etwa 500.000 Quadratkilometer. Das ist gerade mal ein Promille der gesamte Erdeoberfläche, die – ebenfalls grob gerundet – 500 Millionen Quadratkilometer beträgt. Von den gegenwärtigen Wetterbedingungen dieses Promille-Anteils gewisse Rückschlüsse auf die globale Erwärmung abzuleiten, ist gelinde gesagt sehr optimistisch.

Wenn ich mir die Wetterlage dieser Woche in ganz Europa ansehe, bietet sich ein anderes Bild: Hochsommerliche Temperaturen im gesamten Süden und Osten bis weit in den Norden Russlands hinauf. Das östliche Mittelmeer hat momentan 27° C Wassertemperatur, und Westeuropa liegt unter einem ausgedehnten Hoch.

By the way: Der bei uns eher missliche Mai war global gemessen der drittwärmste seit Beginn der Aufzeichnungen.

Re: Ungereimtheiten

Sehr geehrter Herr Prof. Rahmstorf,

ich kann Ihrer Argumentation nicht ganz zustimmen. Meine Fragen wurden m.E. in dem Artikel nur ansatzweise abgedeckt.

Dass die Dissertation von Marcott keinen Temperaturanstieg am Ende der Kurve aufwies, suche ich im Blog vergeblich, ebenso wenig seinen Hinweis, dass genau dieser Anstieg in der Science-Publikation “nicht robust” sei.

Foster erkennt das Problem unterschiedlich langer Proxies (http://tamino.wordpress.com/2013/03/22/the-tick/) mit der möglichen Folge, dass der plötzliche Anstieg im 20. Jhdt. ein Artefakt sein könnte. Dies hat Steve McIntyre klar aufgezeigt. Diese Problematik finde ich in Ihrem Blog nicht hinreichend gewürdigt.

Ihr Hinweis “was allerdings nicht gravierend ist, weil diese Erwärmung ja durch Wetterstationen bestens dokumentiert ist.” ist m.E. nicht hilfreich, weil Messergebnisse aus anderen Quellen nichts mit der Untersuchung durch Marcott et al. zu tun haben. Die Argumentation, dass der Marcott-Uptick real sei, weil ein ähnlicher Kurvenverlauf aus anderen Quellen belegt sei, ist m.E. falsch. Dies hat, wie ich bereits erwähnte, Marcott wohl auch selbst erkannt, weshalb er hier zurückruderte.

Nicht diskutiert hatten Sie auch die Umdatierung einzelner Proxies mit gravierenden Folgen für den zeitlichen Verlauf der Temperaturanomalien. McIntyre hatte dies belegt (http://climateaudit.org/…-shakun-dating-service/).

Foster hatte – wie Sie erwähnten – untersucht, ob Spikes in den Marcott-Proxies verloren gehen können und hat dies negiert. Aufgrund des Abtasttheorems nach Nyquist/Shannon halte ich dies für sehr problematisch. Wenn zufälligerweise ein Peak auf einem Stützpunkt einzelner Proxies liegt, so wird dieser sich sicherlich etwas im Kurvenverlauf niederschlagen. Der Umkehrschluss ist jedoch nicht zwingend. Änderungen in der Größenordnung weniger Jahrzehnte fallen i.a. durch das Grobraster der Marcott-Proxies und sind dann nicht nachweisbar.

Foster argumentiert damit, dass zumindest einige der Proxies doch solche Spikes zeigen sollten, da deren Stützpunkte mehr oder weniger zufällig verteilt seien. Dem stimme ich zu. Genau dies ist aber auch der Fall, wie Marcotts Dissertation zeigt (http://ir.library.oregonstate.edu/…e/1957/21129, S. 200ff).

Sie unterstützen Ihre Argumentation dadurch, dass die Eisbohrkerne aus Grönland und der Antarktis einen “glatten Verlauf ohne eine frühere starke Erwärmung wie im 20. Jahrhundert” zeigen würden. GISP2-Auswertungen z.B. von Easterbrook zeigen jedoch kurzfristige Temperatursprünge, die diejenigen des 20. Jhdt. übertreffen:

http://hot-topic.co.nz/…011/01/GISP210klarge.png

Vielleicht noch ein Kommentar am Rande:

Ich habe ein wenig den Eindruck, dass Sie den Begriff “Skeptiker” in einem abwertenden oder zumindest kritischen Sinne nutzen. Skeptizismuus ist aber einer der Grundpfeiler wissenschaftlichen Arbeitens. Auch halte ich eine pauschale Einordnung von “Klimaskeptikern” in eine Schublade für nicht korrekt.

Sollte mein Eindruck täuschen, korrigieren Sie mich bitte. Darüber würde mich sehr freuen.

MfG

Werner Kohl

[Antwort: Lieber Herr Kohl, gerne möchte ich noch kurz auf Ihre Punkte eingehen.

1. Ich kenne Marcotts Dissertation nicht sondern beziehe mich nur auf das Science Paper, das er mit drei weiteren Autoren publiziert hat. Für die fachliche Bewertung der Analysen in diesem Paper ist es vollkommen irrelevant, welche Teile davon bereits in Marcotts Dissertation enthalten sind.

2. Ich stimme völlig mit Marcott überein, dass diese Proxidaten nicht geeignet sind, die Erwärmung im 20. Jh. robust zu beschreiben. Deshalb schrieb ich oben im Artikel: “Die Erwärmung im 20. Jahrhundert wird also nur ansatzweise erfasst”. Der Grund ist schlicht, dass die meisten dieser Proxireihen schon vorher enden. Aber was wollen Sie daraus schließen? Sie werden ja sicher nicht die Erwärmung im 20. Jh. infrage stellen wollen, die durch Thermometermessungen bestens belegt ist. Wollen Sie die Zuverlässigkeit der Proxies vor 1900 infrage stellen? Nur weil sie nicht bis ins 20 Jh. hineinreichen? Das wäre unlogisch. Zudem gibt es ja als Bindeglied die PAGES 2k Daten in Abb. 3, die die Marcott-Daten und die modernen Messungen gut überlappen.

3. Verschiedene Autoren verwenden in der Paläoklimatologie verschiedene Datierungsmethoden, die teils zu unterschiedlichen Zeitskalen führen. Wenn Sie verschiedene Datenreihen mitteln wollen, müssen Sie die deshalb mit einer konsistenten Methode datieren um alle auf eine konsistente Zeitskala zu bringen. Insbesondere war es notwendig, die Kalibrierung von C14-Alter auf Kalenderjahre bei allen Datenreihen konsistent durchzuführen, wie Marcott et al. bei Realclimate näher erläutert haben. Hätten sie das versäumt, hätte man sie zurecht kritisieren müssen.

4. Das Abtasttheorem nach Nyquist/Shannon bezieht sich darauf, in welchen Abständen sie eine einzelne Kurve abtasten müssen, um das Signal zu rekonstruieren. Das Theorem ist hier nicht anwendbar, weil es nichts darüber aussagt, wie gut Sie einen Mittelwert aus 73 Datenreihen mit sehr unterschiedlichen und irregulären Abtastraten rekonstruieren können. Im Computerzeitalter, wo Sie problemlos 1000 Monte Carlo Simulationen dazu machen können, können Sie das aber ganz einach ausprobieren. Das hat Grant Foster getan, das Ergebnis ist bekannt.

5. Über die Schwankungen in den Grönlanddaten kann man sich streiten – wenn Sie 5 Grönlandkerne mitteln, um das Datenrauschen zu reduzieren, dann sticht die rezente Erwärmung schon heraus. Aber letztlich ist Punkt 4. wichtiger.

6. Ich habe als Forscher großen Respekt vor wissenschaftlichem Skeptizismus – Sie sagen es völlig richtig, es gehört zu den Grundpfeilern der Wissenschaft, immer wieder alles zu hinterfragen und sich nur durch solide Evidenz von etwas überzeugen zu lassen. Deshalb schreibe ich “Klimaskeptiker” meist in Anführungszeichen – weil diese ja gerade nicht diesem gesunden wissenschaftlichen Skeptizismus verpflichtet sind, sondern eher einer Form von Propaganda. Ich verweise dazu auf Teil 2 dieser Reihe – bezüglich McIntyre auch auf das Update darunter vom 3. Juni.

Herziche Grüße, Stefan Rahmstorf]

@w. Kohl

“ich hatte noch vergessen zu erwähnen, dass Marcott auf Anfrage zugab, dass die Daten des 20. Jhdt. “nicht robust” seien.”

….

Ist dieses Eingeständnis(?) (“nicht robust”) dokumentiert?

Falls ja, wäre hierzu ein Link sehr hilfreich (gewesen).

@ Reinhard Koehrer

Sie werden lachen, aber mir ist auch schon aufgefallen, dass Deutschland nur einen kleinen Teil der Erdoberfläche ausmacht. Da aber die Verteidiger der Orthodoxie wenn es irgendwo gerade mal etwas wärmer ist, sofort den Klimawandel hinter dem Ofen hervor zaubern, mag es mir gestattet sein, mich darüber zu wundern, dass die globale Erwärmung augenscheinlich erstaunlich geringe lokale Auswirkungen hat.

Um die Frage der globalen Erwärmung aber nicht komplett aus den Augen zu verlieren, können Sie mir ja vllt. kurz beantworten, wie stark Ihres Erachtens die globale Temperatur in den letzen 15 Jahren gestiegen ist, wie weit dieser Anstieg mittlerweile hinter den Projektionen des IPCC zurückliegt und was die Weltbevölkerung die Bekämpfung des Klimawandels bis dato gekostet hat.

@Bleyfuß

Dieses Eingeständnis beruhte offenbar auf einer Anfrage durch Steve McIntyre.

Am 13. März veröffentlichte McIntyre Marcotts Antwort in

http://climateaudit.org/…3/13/marcott-mystery-1/

Am 31. März gab McIntyre in

http://climateaudit.org/…the-marcott-filibuster/

bekannt, dass Marcotts Eingeständnis der fehlenden Robustheit Teil einer größeren FAQ sei, die Marcotts Team in RealClimate am gleichen Tag veröffentlicht hatte:

http://www.realclimate.org/…se-by-marcott-et-al/

“the small number of datasets that extend into the 20th century (Figure 1G) is insufficient to reconstruct a statistically robust global signal”

@ Brecht

Ich bin Ökonom, aber immerhin am Rande am Thema Klimawandel interessiert, als Experte für “latente Steuern” und ähnlichem Kram kann ich methodologisch sicher nicht allzu sehr mithalten. “Kurzfristige” (und nicht unbedingt vorher prognostizierbare) Schwankungen in einem Rhythmus von 15/20 Jahren (nach oben oder unten) scheinen mir aber bei den Temperaturentwicklungen über Jahrtausende (abgebildet durch Zeitreihen) etwas ganz Normales zu sein. Zum Beispiel gibt es bei der Hockeyschlägerkurve eine deutliche “Delle” zwischen 1900 und 2000. Woher wissen Sie genau, lieber Herr Brecht, dass ohne anthropogene Treibhauswirkung die Temperatur in den letzten 15 Jahren nicht sogar stark gesunken wäre? Auf was wollen Sie hinaus? Was prognostizieren Sie für die nächsten 30/60 Jahre? Wie begründen Sie Ihre Prognose? Immer nur die Nase zu rümpfen ist etwas wenig! Statistik ohne fundierte Theorie (und auch noch mit willkürlich gewählten Zeiträumen) bringt nicht viel, das lernt man eigentlich in jedem Studium schon im zweiten Semester.

MfG

Jürgen Bucher

Lokale Temperaturänderungen

Die Entwicklung der globalen Durchschnittstemperatur ist m.M. nach nur von akademischer Bedeutung solange die Änderung nur im Bereich von wenigen Grad liegt. Für die Landwirtschaft sind z.B. nur die lokalen Temperaturen während der Wachstumsphase der Pflanzen von Bedeutung.

Nun gibt es in den gemäßigten Klimazonen schon immer kalte und warme Sommer, die Durchschnittstemperaturen ändern sich von Jahr zu Jahr um mehrere Grad C ohne dass es zu regelmäßigen Mißernten kommt.

Sollte es lokal gesehen zu gravierenden Änderungen der Sommertemperaturen kommen können die Bauern dies durch die Wahl anderer Saatgut-Varianten, Bewässerungen usw. zumeist ausgleichen. Temperaturprognosen alleine helfen da nicht wirklich weiter da auch die Menge und Zeitpunkte der Niederschläge im Sommer von entscheidender Bedeutung für den Ernteertrag sind. Z.B. führt Dauerregen während der Blütephase zu erheblichen Ernteeinbußen, egal wie optimal das Wetter nach der Blüte ist.

PS: Die höchsten Hektarerträge gibt es übrigens dort wo überhaupt kein Regen auf die Pflanzen niedergeht. Also z.B. in bewässerten Wüstenregionen (Nildelta, Israel usw.) sowie in Gewächshäusern. Für optimales Wachstum benötigen Pflanzen das Wasser nur an den Wurzeln.

@Dr. Brecht

Es ist offenbar ein weit verbreiteter Irrtum, dass sich eine globale Erwärmung schön gleichmäßig über den gesamten Globus verteilt. Dem ist jedoch nicht so. So wird sich der kommende Klimawandel in der Arktis wesentlich nachhaltiger bemerkbar machen als in äquatornahen Regionen, und auch stark ausgeprägte lokale Unterschiede gehören dabei zur Tagesordnung (dieses Thema wurde in diesem Blog erst vor kurzem erörtert: Extremwetter durch planetare Wellen). Auch die klimatische Relevanz von Hitzewellen und Dürreperioden wurde in diesem Blog schon ausführlich behandelt.

https://scilogs.spektrum.de/…8-19/hitzewellen-weltweit

Vor allem jedoch ändert eine zwischenzeitlich kühlere Wetterlage in manchen Ländern nichts an der Strahlungsbilanz der Erde: Der Energiehaushalt des Planeten ist gewissermaßen ein Nullsummenspiel, und wenn hierzulande einige Wochen lang Kühle herrscht, ist es andernorts entsprechend wärmer.

http://de.wikipedia.org/…hlungshaushalt_der_Erde

Ihre postulierte „Nichterwärmung“ beruht offenbar auf der beliebten Skeptiker-Jahresreihe 1998 bis 2012, wobei 1998 bekanntlich eines der wärmsten Jahre überhaupt war. Ich schlage Ihnen ein kleines Experiment vor: Warten Sie noch einige Monate und erstellen Sie dann eine neue Berechnung auf der Basis von 1999 bis 2013: Ich wette, dass sich der Temperaturverlauf dann völlig anders präsentiert. Was klar zeigen würde, dass ein 15-Jahres-Trend alles andere als robust ist und im Grunde keine verlässlichen Aussagen erlaubt.

Die weltumspannenden Kosten für den Klimaschutz sind in pauschaler Form kaum zu beziffern, da jede Studie andere Claims absteckt und die Grenzen zwischen infrastrukturellen und klimatisch bedingten Maßnahmen verschwimmen. Wo würden Sie zum Beispiel ein Brunnenbohrprojekt in der südlichen Sahelzone einordnen? Abgesehen davon wird bei dieser Frage eher umgekehrt ein Schuh daraus, nämlich welche Kosten anfallen, wenn nicht oder zu wenig investiert wird: Das Spektrum der Folgeschäden würde von extrem teuer bis unbezahlbar reichen.

Immerhin nimmt langsam auch in politischen Kreisen die Einsicht zu, dass Vorsorge immer noch billiger ist als die Hände in den Schoß zu legen. Ein aktuelles Beispiel bietet der folgende Link:

http://www.heise.de/tp/blogs/2/154485

@W Kohl

Nunja, um die Temperaturentwicklung der neueren Zeit (rd. 200 Jahre) zu beschreiben, sind Sedimentanalysen vermutlich nicht die bequemste Methode.

Und auch wenn die Methode nicht robust sein mag, so ist sie doch konsistent mit den Resultaten aus anderen Bereichen.

Eingeständnis?

@ Werner Kohl

Die Rekonstruktion der Temperatur für das Holozän hat für das 20. Jh. keine robuste Datenbasis. Ja und? Stefan Rahmstorf hat dies im Artikel auch deutlich erwähnt, auch den Grund (Grenze der Sedimentkerne) und das es für diesen Zeitraum selbstverständlich direkte Messungen gibt.

Und was schließen Sie jetzt aus diesem “Eingeständis”?

Es gibt kein “Eingeständnis”. Schon in Marcott et al. 2013 (das wir alle gelesen haben, richtig?) steht

Also: diese Data kann uns nichts erzählen über den modernen Aufschwung. Klar?

[Antwort: Hallo Martin, richtig: was auf “Klimaskeptiker”-Websites als späteres “Eingeständnis” und “Zurückrudern” gefeiert wurde, steht bereits in dem Paper. Ich finde “nichts erzählen” aber auch etwas übertrieben – Foster zeigt ja, dass man durchaus vernünftige Ergebnisse auch für den Aufschwung am Ende bekommt, wenn man statt naives Mitteln statistische Verfahren verwendet, die die Abnahme der Anzahl der Datenreihen berücksichtigen, z.B. RegEM oder die Differenzmethode. Stefan Rahmstorf]

Re: Ungereimtheiten

Sehr geehrter Herr Prof. Rahmstorf,

Ihre Antwort ist einerseits eine Bestätigung meiner Argumente, gleichzeitig aber ein frustrierendes Erlebnis.

Sie stimmen diesem Eingeständnis von Marcott et al. zu:

“the small number of datasets that extend into the 20th century (Figure 1G) is insufficient to reconstruct a statistically robust global signal”

Weiterhin konnte ich Ihnen anhand der der Science-Publikation zugrunde liegenden Dissertation zeigen, dass einzelne Proxies genau das Verhalten zeigen, das Foster gefordert hatte, falls es in der Vergangenheit kurzzeitige “Spikes” gegeben hatte.

Kernaussagen Ihres Blog waren aber u.a.:

“Dass der Verlauf in den letzten eintausend Jahren praktisch identisch ist, ist übrigens auch eine weitere Bestätigung des „Hockeyschlägers“ von Mann et al. 1999”

“Entscheidend ist vielmehr, dass der rasche Anstieg im 20. Jahrhundert im ganzen Holozän einmalig ist.”

“Es gibt auch eine Reihe von hochaufgelösten Proxydaten über das Holozän [.. ]. Sie zeigen einen glatten Verlauf ohne eine frühere starke Erwärmung wie im 20. Jahrhundert. Hätte es eine solche globale Erwärmung schon einmal gegeben, müsste man sie zumindest in einigen Datenreihen deutlich sehen, selbst wenn sie in der gemittelten Marcott-Kurve untergeht.”

“wir sind dabei, uns weit aus dem Holozän herauszukatapultieren.”

Alle diese Aussagen sind damit in Bezug auf die Arbeit von Marcott et al. Makulatur.

Natürlich ist es unbestritten, dass es seit der Kleinen Eiszeit eine signifikante Temperaturerhöhung gegeben hat. Jedoch ist die Arbeit von Marcott et al. – so interessant und wichtig sie für die Analyse des Holozän ist – völlig ungeeignet, um Analysen des 20. Jahrhunderts anzustellen.

Anstatt die Leute mit dem “Rollstuhl” – manchmal auch als “Sense” (“scythe”) bezeichnet (http://climatecrocks.com/…-stick-new-the-scythe/) – zu erschrecken, hätte ich erwartet, dass Sie zugeben, dass dieses Paper absolut nichts mit der Diskussion über die aktuelle Erwärmung des 20. bzw. 21. Jahrhunderts zu tun hat. Dass Sie dies unterlassen, ist für mich sehr frustrierend.

Mit freundlichen Grüßen

Werner Kohl

[Antwort: Lieber Herr Kohl, da müssen wir wohl “agree to disagree”. Kein Problem. Für mich existiert das Marcott et al. Paper nicht in einem Vakuum sondern im Kontext vieler anderer Forschungsergebnisse und Daten, und sollte z.B. zusammen mit den Messdaten aus dem 20. Jh. (Abb. 1) und den hochauflösenden Proxies von PAGES 2k (Abb. 3) diskutiert werden. Stefan Rahmstorf]

@Bleyfuß, @Paul Stefan

> Und was schließen Sie jetzt aus diesem “Eingeständis”?

Der Schluss sollte Ihnen doch klar sein:

Die Proxies der Holozän-Analyse durch Marcott et al. sind völlig ungeeignet, um Aussagen über die Temperaturentwicklung des 20. oder gar 21. Jahrhunderts zu treffen. Deshalb sollten sie aus der aktuellen Diskussion über die AGW herausgehalten werden.

Noch 2 Kommentare:

1. Abb. 1 ist aufgrund völlig unterschiedlicher zeitlicher Auflösung der Proxies und moderner Aufzeichnungen m.E. wissenschaftlich unhaltbar.

2. Die Extrapolation der Abb. 4 bis zum Jahr 2100 ist pure Spekulation, da hier zugrunde gelegt wird, dass die Temperatur bis dahin einfach so um 3 Grad ansteigen wird. Warum nicht gleich um 5 oder 10 Grad? Das würde noch dramatischer wirken. In einem Wissenschafts-Blog hat eine solche Grafik m.E. nichts verloren.

[Antwort: Lieber Herr Kohl, die Temperatur steigt in der Grafik nicht “einfach so” um 3 Grad, sondern es handelt sich um ein wissenschaftlich in der Fachliteratur sehr gut begründetes moderates Zukunftsszenario auf Basis der zu erwartenden künftigen Treibhausgasemissionen. Stefan Rahmstorf]

Temperatur-Szenarien

Sehr geehrter Herr Prof. Rahmstorf,

wenn es um die reine Kurve 1979 (o.ä.) bis 2100 geht, sind wir völlig konform. Das ist eben die grafische Darstellung eines bestimmten Modellszenarios unter der Annahme einer bestimmten CO2-Sensitivität im Zusammenspiel mit gewissen positiven Rückkopplungen. Damit habe ich kein Problem.

Unsere Meinungen gegen eben auseinander in Bezug auf die Frage, welchen Sinn die Kopplung einer solchen Kurve mit der “Marcott”-Kurve macht. Hier werden wir wohl keinen Konsens erreichen. Daher ist es wohl sinnvoll, die Diskussion an dieser Stelle zu beenden.

Vielleicht ergibt sich an anderer Stelle ein interessantes Diskussionsthema.

Brennend interessieren würde mich beispielsweise der Grund für die enorm hohe Atmosphärentemperatur in Oberflächennähe der Venus. Hier habe ich absolut keine Idee. Das von manchen auf der EIKE-Seite gebrachte Argument, das läge am hohen Atmosphärendruck (adiabatische Kontraktion) ist natürlich barer Unsinn, da hier wohl ein stationärer Zustand vorliegt. Aber auch der logarithmische Zusammenhang zwischen CO2-Konzentrationserhöhung und Temperaturerhöhung würde auch bei hoher Sensitivität nicht ausreichen.

Wäre das nicht ein schönes Thema für ein Blog?

Mit freundlichen Grüßen

Werner Kohl

[Antwort: Danke für die Anregung! Stefan Rahmstorf]

Sommertipp

So ganz langsam wird die arktische Meereisbedeckung wieder aktuell. In zwei bis drei Wochen könnte sich ein erster signifikanter Trend abzeichnen. Tagesaktuell unter folgendem Link zu finden:

http://www.ijis.iarc.uaf.edu/…/seaice_extent.htm

Fragen im Kontext

Sehr dankbar wäre ich um Hinweise zu folgenden Fragen, die mich schon länger umtreiben.

Feststellung:

1. Die sehr hohe Sommereinstrahlung in den nördlichen Breiten laut dem mittleren Bild in Abblidung 2 hat von -11000 bis – 8000 ihren Höhepunkt und nimmt dann ab. Der globale Temperaturverlauf steigt erst um -8000 stark und “schnell” an und hat bis -4000 einen Höhepunkt, um dann langsam abzusinken.

2. Die gängige These hinter den Orbitalzyklen wird gemäß dem allgemeinen Konsens so beschrieben: “Das Klimasystem reagiert besonders empfindlich auf diese [lokale] Sommereinstrahlung, weil sie durch die Schnee- und Eis-Albedo-Rückkopplung verstärkt wird.”

Fragen:

1. Welchen Einfluss hat nun das CO2 mit seiner Rückkopplung?

Skeptikerthese:

Der schnelle T-Anstieg bis -8000, der T-Rückgang dann parallel zur Abnahme der Jahreseinstrahlung (unteres Bild in Abb. 2) passt nicht: Ein verstärkender CO2-Feedback müsste den Temperaturanstieg doch noch für eine Weile weiter fort führen? Die Grenzen des CO2-Feedbacks sind doch schnell erreicht (mit der Folgerung einer niedrigen Klimasensitivität), wenn lokale Einstrahlung mit Stärken bis zu 60 W/m2 das Steuer am Klimasystem faktisch übernehmen und umsteuern.

2. TSI Werte werden vernachlässigt, weil nur geringe Veränderungen feststellbar sind. Ich verstehe die TSI (und CO2) immer noch wie eine Art Basislinie und unabhängig davon die lokale Einstrahlung im Einzelfall als möglicher lokaler, die Basislinie überschreibender, “Zündfunke” für globale Klimasystemänderungen.

Nun gibt es aber eine TSI-Rekonstruktion von Shapiro (2011) für -500 bis 2000, welche den TSI-Verlauf mit dem T-Verlauf in ein klares Verhältnis zu setzen scheint (d.h. Folgerung einer niedrigen Klimasensitivität für CO2). Gibt es Rekonstruktionen von TSI-Werten für den hier bei Ihnen dargestellten Zeitraum?

Wahnsinnsschmelzrate derzeit

200.000 km2/Tag von 17. auf 18 Juli.

Die 2013er Kurve wird die Kurvenverläufe der Rekordminima alsbald unterbieten, wenn die Schmelzrate weiterhin auf solch hohem Niveau bleibt.

Hallo Herr Rahmstorf,

zu ihren Punkten 1-3, weshalb der aktuelle Erwärmungstrend so außergewöhnlich ist, hätte ich noch eine Frage.

Sie weisen auf die hochauflösenden Temperaturrekonstruktionen mithilfe von Eisbohrkernen hin. Jetzt finde ich auf den Seiten des österreichichen ZAMG folgendes Statement: “Verschwommenes Gasalter: Die Gasproben in den tiefen Eisbohrkernen liefern somit langjährige Mittelwerte und könnten einen schnellen Temperaturanstieg, wie er zurzeit vor sich geht, gar nicht erfassen. Der jüngste Punkt auf der berühmten CO2-Kurve aus den antarktischen Tiefbohrkernen Vostok und EPICA in Abbildung 3 ist sicherheitshalber mit mehr als 2000 Jahren vor heute angegeben. Das bedeutet nicht, dass das Eis, in dem sich die Luftblasen befinden, schlecht datierbar wäre, sondern nur dass die im fixen Eisgerüst beweglichen Gase weniger exakt greifbar sind.” (Quelle: http://www.zamg.ac.at/cms/de/klima/informationsportal-klimawandel/klimaforschung/klimarekonstruktion/eisbohrkerne)

Ist diese Information richtig oder verzerrt? Inwiefern halten Sie die Eisbohrkerne dennoch für geeignet, schnelle Temperaturanstiege anzuzeigen? Ist angesichts von 1 Mio Jahre Klimageschichte ein Mittel über 1000 Jahre einfach schon ein guter Wert? Oder gibt es noch andere hochauflösende Datenreihen?

Vielen Dank, falls Sie Zeit für eine Anmerkung finden.

Insgesamt finde ich die 3 Punkte, insbesondere Nr3 schon überzeugend.